初めに

Nutanix CE2.0を12回 + CE2.1を2回構築した経験を持つブログ管理人が誰でも構築できるようにスクリーンショット付きで丁寧に解説します。既に先駆者の方が作成されたブログでも、もちろんできなくはないですが、一部、手順がないところがありまして、初見の方だと厳しいところがあります。そのようなところを含めて解説します。

2024/8/31追記:CE2.0からCE2.1のアージョンアップは可能でした。CE2.1ではAOS6.8となります。Prism Elementでは大きな差異はありません。しかし、Prism Central 2024.1からはUIがかなり変わります。

Nutanix CEの構築が2回目以降の方へ

よりシンプルな手順を作成しました。こちらをご利用ください。

サイジング

シングルノードクラスター

- CPU コア数:4以上

- メモリ:32GB以上

- ディスク容量:430GB以上

Prism Central(以下、PCと省略するかもしれません)と呼ばれる、クラスターを統合管理するVMをデプロイする場合は、上記に加えて更にリソースが必要となります。

- CPUコア数:6以上

- メモリ:26GB(※)以上

- ディスク:500G以上

※pc.2024..1~ではメモリ要件が変化しています。最低でもメモリ28GB~必要です。

つまり、シングルノードクラスターでPCVMを構築する場合は

- CPUコア数:10コア以上

- メモリ:58GB(※)以上

- ディスク:930GB以上

※pc.2024.1~では60GB以上です。

が最小要件となります。実際にはここまで使用しませんが構築時にこの要件を満たさないとデプロイに失敗する可能性があります。

シングルノードクラスターではPrism Centralを使用することはできない可能性があります。Registerに失敗します。もしかしたらPrism Centralのバージョンなどが起因するかもしれません。AOS6.5.6、Prism Central 2022.6.0.11では失敗します。

2024/7/1更新:成功しました。タイミングによる…のかもしれません。

3ノードクラスター

シングルノードのリソースに3を乗じるだけです。

つまり、メモリは最低でも96GB必要となります。また、ディスクも約1.3TBは最低でも必要です。

Tips:後ほど作成するCVM用のディスク(200GB~)は必ずSSD or NVMeにしましょう。

3ノードクラスターをミニPCで構築してみたい!と、ご検討の方は次の記事をご覧ください。

Prism Centralの運用方法について管理人の意見を述べています。

先に関連記事のご紹介(新)

現在公開している記事を体系的に整理しました。こちらを参照ください。

先に関連記事のご紹介(旧)

Nutanix CE2.1をESXiで3台構成で構築しました。その時の備忘録です。

Nutanix CEがプロキシサーバ経由で通信をする必要がある場合、事前にいくつかURLを許可しておく必要があります。プロキシサーバの設定方法から許可するべきURL、DNSサーバ設定時の注意点についても解説しております。

2024/8/30まで

Nutanix Universityの無料コースを完了させると、対象コースのバウチャーが貰えます。バウチャーは適用期限があるので、貰ったらすぐに仮日で良いので試験予約しておきましょう。

Nutanix Universityや試験のスケジュール方法について解説しました。

ドキュメントの種類について解説しています。

製品(SQL Server, MySQL, PostgreSQL, Oracle, Citrix, SAP HANA, Linuxなど)毎に、Nutanixで構築・運用していくためのノウハウが整理されたドキュメントもございます。

間違いなく知っておくべきですので、一読をお勧めします。

Nutanixの仮想マシンについて解説しています。

AHV、AOS、Prism Centralでは電源ON可能なVM数やvDisk数などの上限値があります。そちらについて解説しました。

GUIで仮想マシンを作成したあと、SSHやRDPでログインできる状態にするために、しばしばコンソール画面でコマンドを投入する必要があります。しかし、配列が異なるため上手く記号を入力することができません。備忘として作成した対応表を参考にご利用ください。

Prism Centralの登録方法についてスクリーンショット付きで解説しています。

Prism Central 2024.1からトライアルライセンスの有効化が必要となりました。有効化方法について解説しています。

Prism Centralで提供されている機能である、ストレージポリシーについて図付きで説明しております。

LCMと呼ばれるソフトウェアの依存性を考慮してアップグレードを行うことが出来るツールがあります。ソフトウェアのアップグレードを行う前にすべきこと、アップグレードの順序性などについて解説しました。

仮想マシンを作成するためにはイメージファイルを登録しておく必要があります。スクショ付きで解説しました。

イメージ配置ポリシーという、カテゴリを使用してイメージファイルの配置を柔軟に制御する機能があります。初見だとなかなか厳しいためスクショ付きで解説しています。

NutanixのブロックストレージサービスであるNutanix Volumesについて解説しています。Volume Groupを使用することで、クラスター全体でI/O処理を分散化することが可能です。

CVMの主要なコンポーネントについて14種類解説しました。

Nutanixでは各機能をどのような仕組みで提供しているか理解するのに参照ください。

ランダム書き込みI/OバッファであるOpLogの役割、予約容量の計算方法について解説しています。

読み取りキャッシュであるUnified Cacheについて、役割や予約容量の計算方法について解説しています。

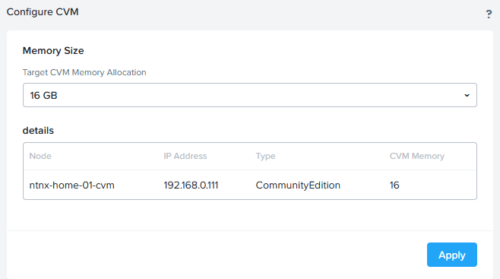

CVMのvCPUやメモリはvirshコマンドを使用して修正することができます。

CVMのリソースを調整したい場合に参考としてください。

NutanixではPrismと呼ばれるWebコンソールで操作することが多いです。マウス操作よりもワンランク上の操作性を求める方は次の記事でショートカットを学んでいただけると良いでしょう。

NutanixのNWとVGに関連するベストプラクティスを1つの記事として整理しました。様々なドキュメントに書かれている推奨事項をまとめているので、新しく導入される方などはご参考ください。

より高度なVMの管理機能を提供するNutanix Guest Toolについて解説しています。

ユーザーの作成やロールについて解説しています。

Nutanixで扱うことのできるCLIコマンドについて解説しております。

VMを安定的に動作させるために理解するべきアフィニティとアンチアフィニティについてはこちらで解説しております。

ノードがダウンした場合に必ず他のノードで再起動するようにするにはVMHAについて設計する必要があります。次の記事で丁寧に解説しております。

デフォルトで作成されているストレージコンテナーの種類、高度な設定項目について解説しています。

virshコマンドを使用することができます。業務で知っておくと役には立つvirshコマンドを実例を踏まえて載せています。

性能を気にする仮想マシンを動作させているならば、NUMAノードについて理解する必要があります。こちらの記事で解説しています。

ログの保存場所、種類、SYSLOGサーバの設定や注意事項について整理しました。

ログ取得収集ツールであるlogbayの使い方を丁寧に解説しました。Nutanix CE 2.0はサポートがないため、不具合があった場合は自助努力で対処が必要です。その一環として日頃からログを見る癖はつけておくと良いと思われます。

Nutanix Test Driveの使用方法について紹介しています。

Nuanixの初級・中級レベルの資格を受験し無事に合格しました。詳しいことについては以下の記事で紹介しています。

VMware Workstation Proで3ノード構成を実現しようと思いました。

結論から申し上げますと無理でした→可能です。

NutanixにNested Nutanixクラスターを構築したい方もいらっしゃると思います。こちらの記事にノウハウを整理しています。

AHVのIPアドレス変更方法について解説しています。

CVMのIPアドレス変更方法について解説しています。

CVMの停止を含むAHVクラスターの安全な停止方法について解説しています。

vNICのオプション機能であるVirtIO-Net Multi-Queueについて簡単な説明と検証をしております。アプリケーションのパフォーマンス向上に寄与する機能です。

CLIでVMの作成・更新を行う場合に使用可能なオプションについて整理しました。

Nutanix Guest Toolで可能なことについて、先人達の記事を整理しました。

Community Edition 2.0(2.1)の入手

Community Editionへアクセスします。下記URLから入ることができます。

アカウントをまだ作成していない方はこの機会に作成してください。

1点注意点があります。会社用のメールアドレスしか登録できないため、@gmail.comなどは使用できません。

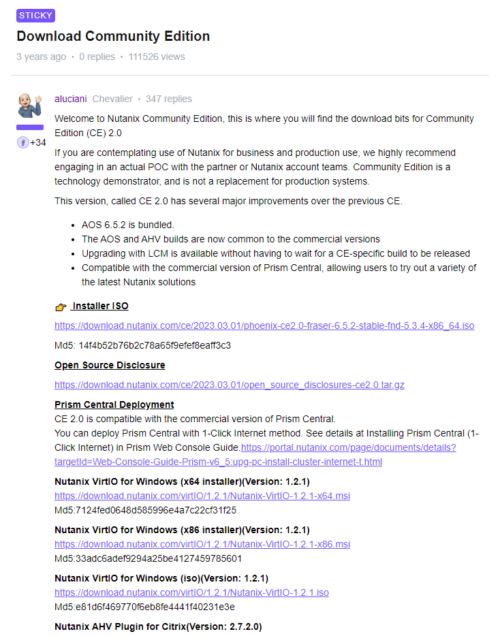

Community Editionへアクセスすると、Nutanix CEのイメージファイル(iso)に関するリンクがまとめられたフォーラムが開かれます。この中から、Installer ISOをクリックしてください。すると、ダウンロードが開始されます。Windows Serverを動かす場合には VirtIOが必須となります。必要であればこの機会にダウンロードしておきましょう。

今回はVMware Workstationへインストールします。

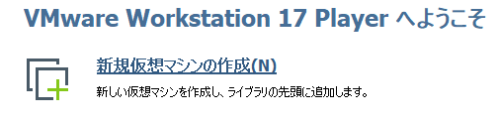

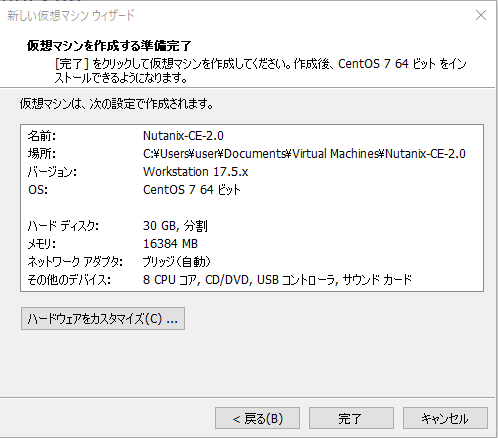

VMware Workstationで新規仮想マシンの作成

VMware ESXiを起動します。新規仮想マシンの作成をクリックします。

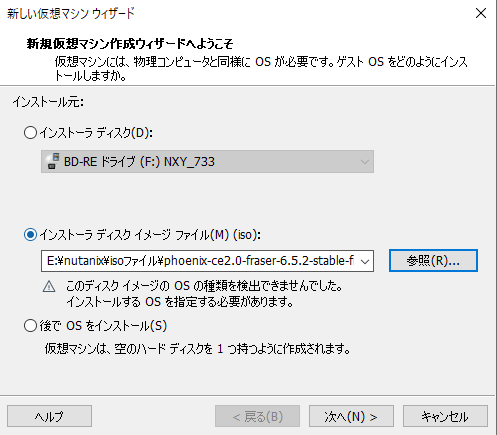

インストーラーディスクイメージファイルに先ほどダウンロードしたISOファイルをセットします。問題無ければ次へを押下します。

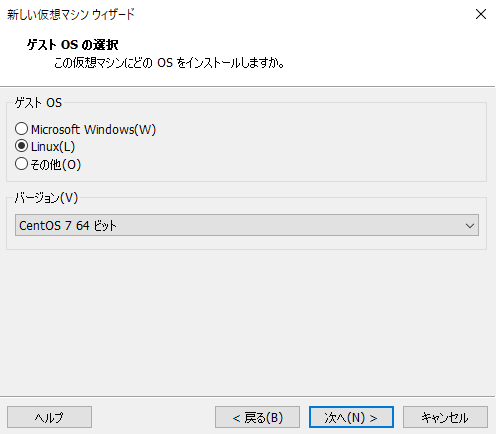

ゲストOSはLinux、バージョンはCentOS 64ビットを選択します。

問題なければ、次へを押下します。

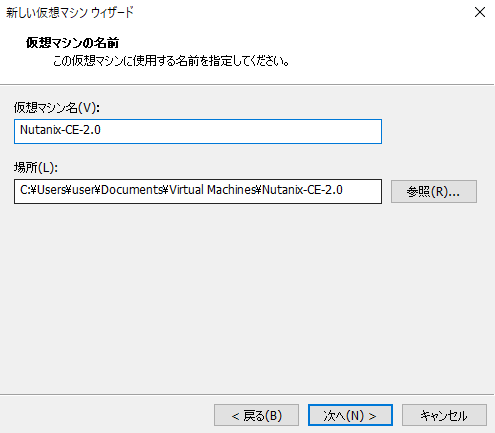

仮想マシンの名前を定義する必要があります。何でもよいので入力したら次へをクリックします。

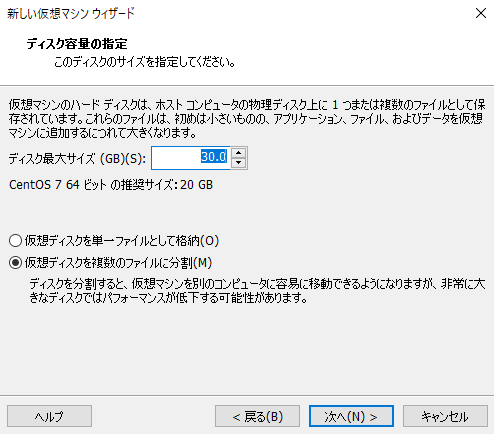

次にディスクサイズを指定します。AHVと呼ばれるハイパーバイザー用のディスクとなります。

ここでは30GB以上で問題ありません。

小さくすると起動に失敗します。多すぎても過剰となるため30GBで問題ありません。

ハードウェアをカスタマイズをクリックします。

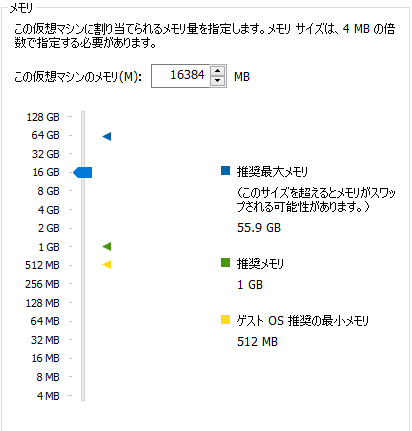

メモリを増やします。Nutanixで全てのI/Oを司るCVM(Controller VM)は大量のメモリを使用します。今回は16GBとします→32GBにしてください(公式ドキュメント上の最小要件は20GB)。メモリは可能な限り大きくしてください。

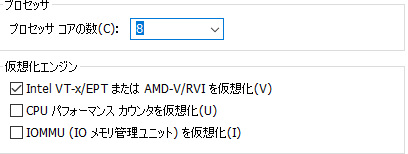

プロセッサはコア数8としました。少なすぎると起動に失敗するかもしれません。

また、必ず「Intel VT-x/EPTまたはAMD-V/RVIを仮想化」にチェックを入れてください。

イメージのインストール最中に失敗します。

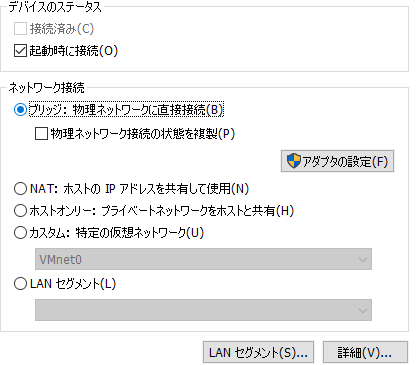

デバイスのステータスでは、ネットワーク接続をお好みで修正します。

ここでは、ブリッジ接続にすることでブロードキャストドメイン内にある全ての機器とルーティングすることなく接続可能とします。また、外部からアクセスすることもできます。

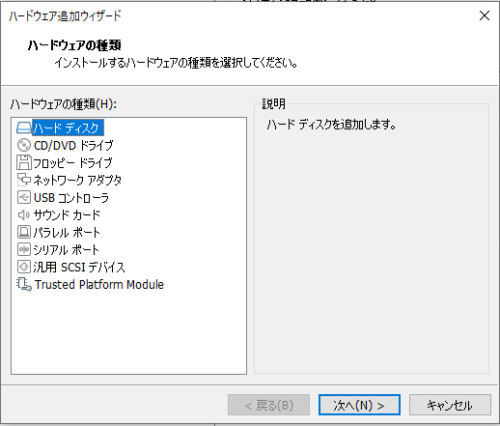

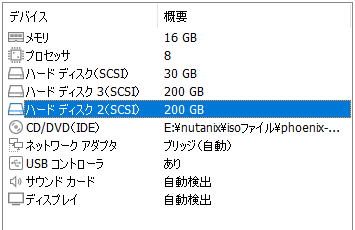

Nutanix CE2.0ではハードディスクが3つ必要となります。

AHV用途、CVM用途、その他データディスク用途となります。

AHV用途のものは既に作成済みなので、あと2つ追加いたします。

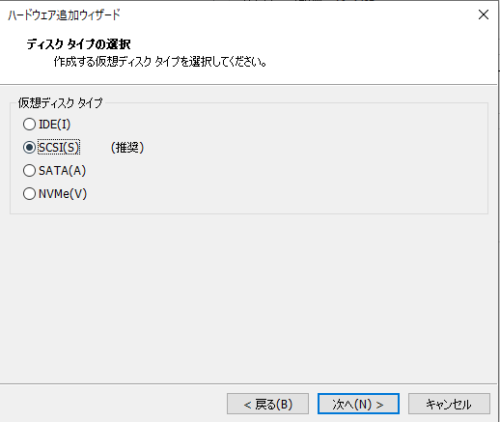

接続タイプはデフォルトのSCSIとしてください。

こちら、管理人が試したところ、物理ディスクがNVMeの場合でもSCSIを選択しなければ、AHVのインストールがタイムアウトして失敗します。

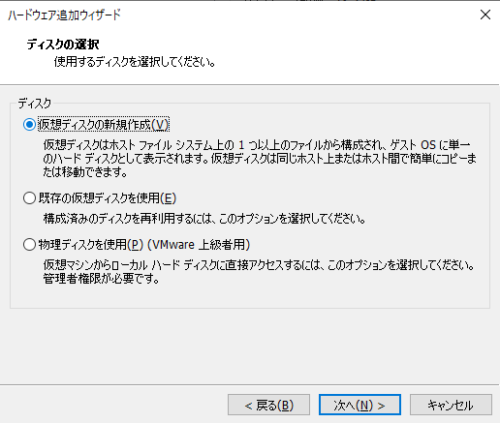

仮想ディスクの新規作成を選択した状態で次へをクリックします。

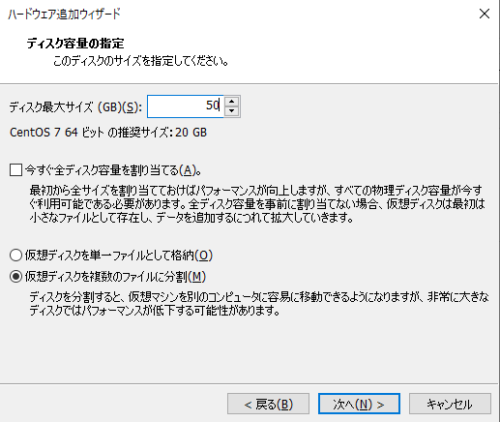

良く確認したら、CVMとData用のディスクは最低200GB以上用意する必要があります。

図では50GBとなっておりますが、必ず200GB以上で設定してください。

インストール時のIPアドレスを設定する画面で次に進めません。

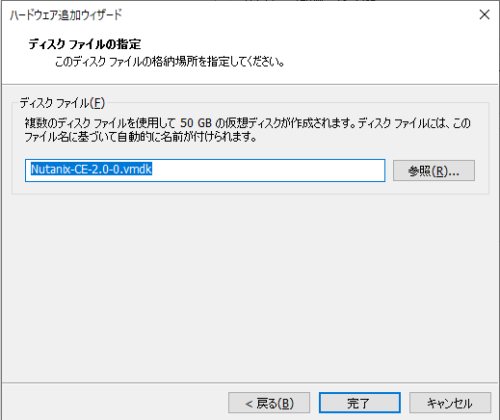

お好みで名前を変更します。完了ボタンをクリックします。

問題なければ、完了ボタンをクリックします。

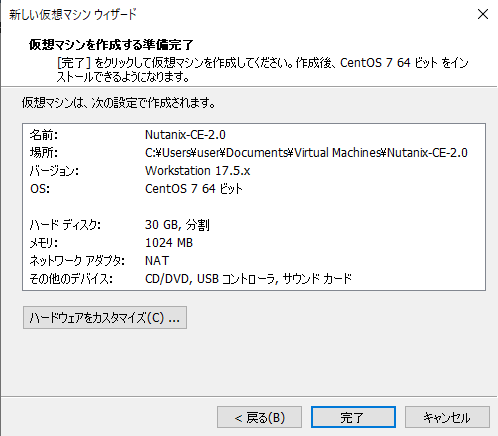

以下の図のような設定値になっていればいったん問題ありません。

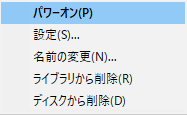

電源をONにします。新しく作成した仮想マシンの上で右クリックしてパワーオンを選択します。

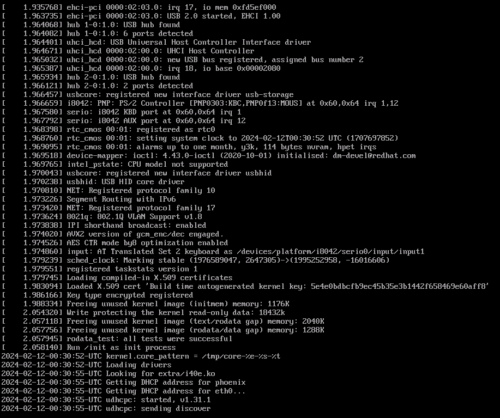

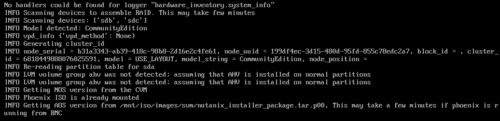

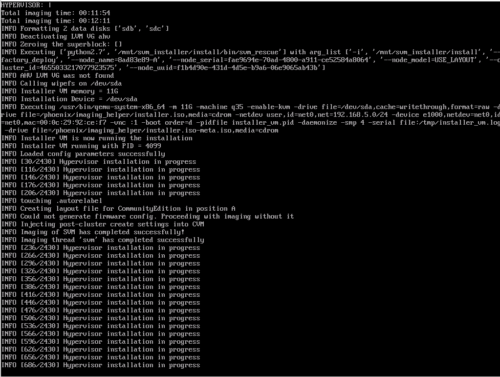

起動すると、しばらく以下のような画面が表示されます。

暫く待ちましょう。2分~程度が目安です。ブログ管理人の場合は、3分程度でした。

今回は直接ISOファイルとしてアタッチしてますが、例えば仮想マウントといったNW越しにISOファイルをマウントする場合は、帯域が細いとGetting AOS version~のままとなります。

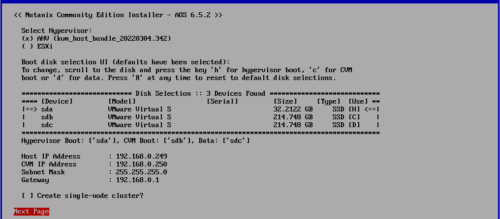

一番大事な画面の1つ、管理情報入力画面に遷移しました。移動はtabキー、選択はスペースキーで可能です。

Select Hypervisorでは、必ずAHVを選択してください。Community Edition2.0からはESXiが使用不可となりました。

Boot Diskは触らなくても良いですが、必要に応じて修正してください。

IPアドレスは2つ使用します。1つめがAHV用(Host IP Address)、2つ目がCVM(CVM IP Address)となります。同セグメントにしてください。

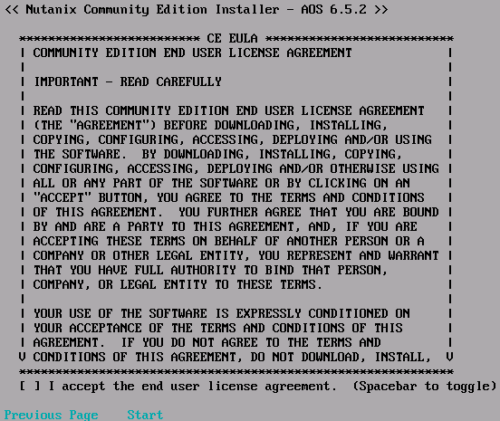

Next Pageを押して少しすると、ライセンス条項のページに遷移します。

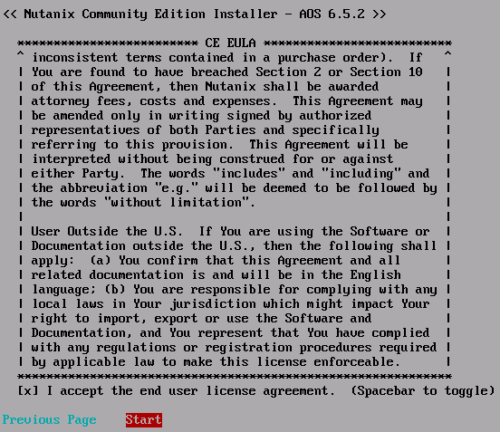

必ず、ライセンスを最後までスクロールしてから同意しましょう。インストールに失敗します。なお、すぐに気づけますし、後戻りもできますので、忘れてもそこまでダメージはありません。

右端の「U」のような印がなくなるまで下にスクロールします。

検証用に1台だけ作成する場合は、I accept the~にスペースキーでチェックを打ってください。後述するクラスター構築コマンドでもシングルクラスターの作成は可能ですが、ディスクの認識に失敗してログイン後のダッシュボードでエラーが出ます。

問題なければStartを選択したままエンターキーを押します。

その後、イメージファイルからAHVやCVMのインストール作業が開始されます。20分~以上かかりますのでしばらく放置します。ブログ管理人の経験上、インストールが完了するまでの長さは、物理サーバーに搭載されているCPUの性能に左右される印象がありますが、真偽のほどは不明です。図のように、xxx/2430とありますが、2430まで行くことはまずありません。2430まで行く場合はインストールが上手くいかずタイムアウトになる場合です。

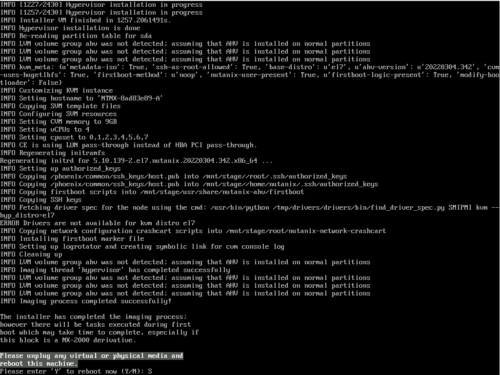

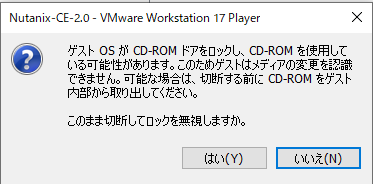

インストールに成功すると、下記のようにISOファイルをアンマウントするように求められます。

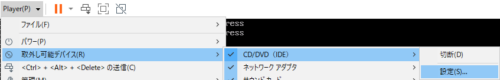

設定をクリックします。

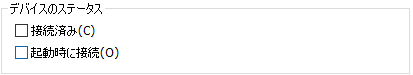

デバイスのステータスのチェックボックスを2つも外します。

OKボタンをクリックすると、下記のような警告画面が表示されます。はいをクリックします。

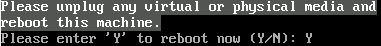

外れていることを確認したら、Yを入力しエンターキーを押します。

すると、再起動されます。少しの間、下記の画面が表示されます。

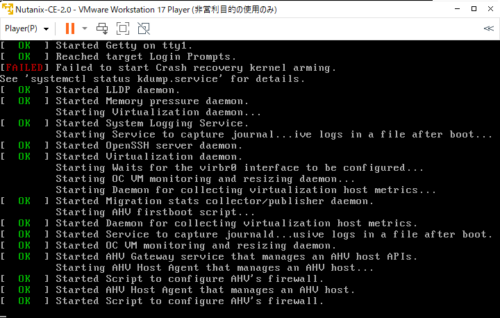

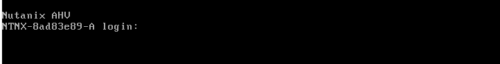

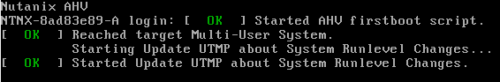

そして、次の画面が表示されたらいったん正常にインストールできた証です。

しかし、実はこの裏でまだCVMの起動の準備が行われています。5分~ほど待機しましょう。以下の画面が表示されてしばらく待ってからAHVやCVMにアクセスします。

クラスターの作成から初期設定まで

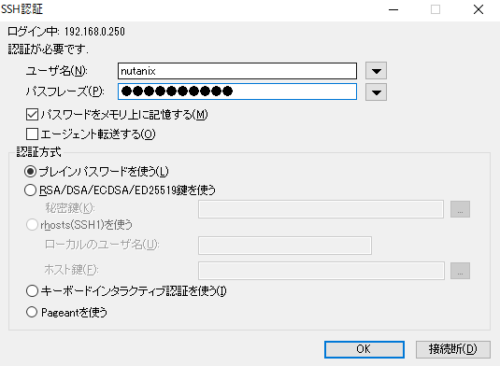

CVMへSSHでアクセスします。初期の認証情報は下記となります。

ユーザー名:nutanix

パスワード:nutanix/4u

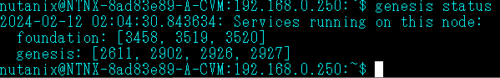

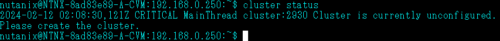

genesis statusと入力してみると、foundationとgenesisのみサービス起動していることがわかります。これでは、Webコンソール画面が表示されません。

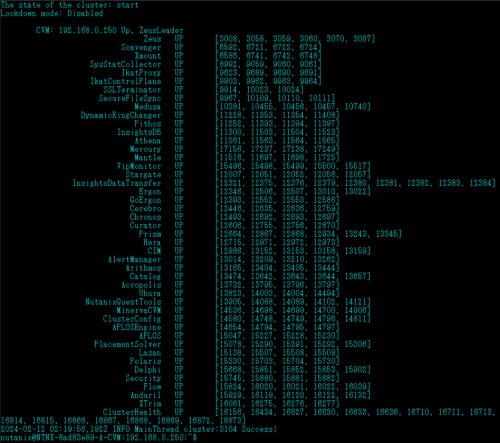

また、クラスターの状態を確認してみましょう。cluster statusと入力します。まだ、クラスターが構築されていないこともわかります。

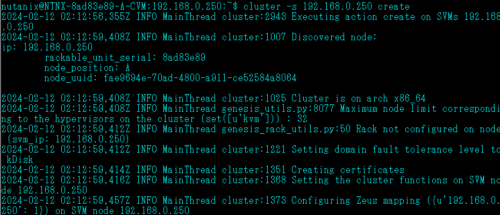

そこで、下記のコマンドを入力してクラスターを新規作成します。

cluster -s CVM_IP_ADDRESS1,CVM_IP_ADDRESS2,CVM_IP_ADDRESS3 create

複数台ある場合は、例のように、CVMのIPアドレスを順番に入力します。お勤めの方で会社内に余っているサーバを複数台駆使してクラスターを構築する場合は、事前に少なくとも3台分はインストール作業を完了させておきましょう。

単体でクラスターを構築する場合、CVMのIPアドレスは1つのみでよいです。しかし、1点注意点が…。明示的に冗長性がないことを明示するオプションを投入する必要があります。そのため、cluster -s CVM_IP_ADDRESS –redundancy_factor=1 create を投入してください。–redundancy_factor=1を忘れて投入すると、後述のようにWebコンソールログイン時のダッシュボードがエラーとなります。その場合は、SettingsからGUIでredundancy_factorを1にし、CVMを再起動して再度クラスターをstartしても直りません。クラスターを破壊して再度構築し直す必要があります。

シングルクラスターの場合は障害発生時にデータが消失します。お試しで作成する分には問題ないです。

また、2台のノードでクラスターを作成することはできません。ただし、ROBO(Remote Office Branch Office)のような環境で、Witness VMを用いて2台のノードを監視する構成にすることで、片方のシングルノードがダウンした場合にもう片方のノードを使用することは可能です(Nutanix CEで出来るかは不明)。

※Nutanix CE2.0では1 or 3 or 4台のクラスターをサポートしていると公式ドキュメントに記載されていますが、初期クラスター構築時には何台でも可能みたいです(Nutanix Meetup @youtubeより)。ただし、縮小などができないはずです。ちなみに、AHVでは最大32台まで1つのクラスターにすることが可能です。誤家庭の方は是非挑戦してください!CE2.0では不可能となりますが、ESXiを選択した場合は、64台までサポートしています!

今回は、検証用途としてシングルノードクラスターとして構築するため、CVMのIPアドレスは1つのみとします。Nutanix CEの管理情報入力画面にてシングルクラスターにチェックを入れなくても、ここでシングル構成にすることが可能です。

シングルノードクラスターについては下記のドキュメントにて簡潔に整理されています。

各サービスが正常に起動するまで数分待ちます。

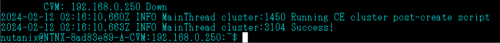

下記の画面が表示されたら成功となります。

この状態では、まだ一部のサービスしか起動していません。

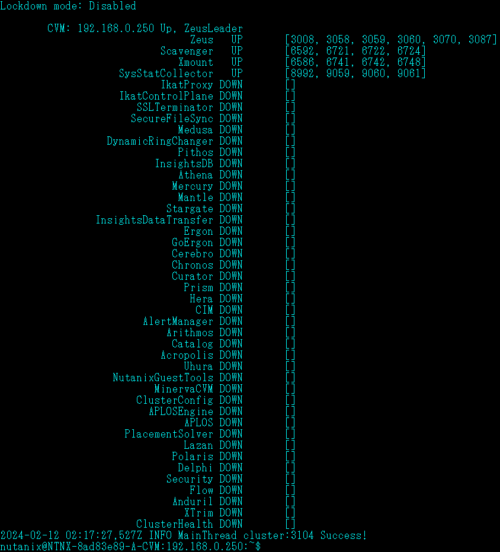

試しにcluster statusを入力してみます。

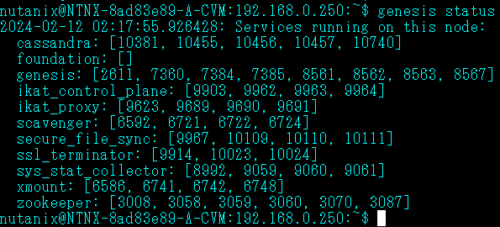

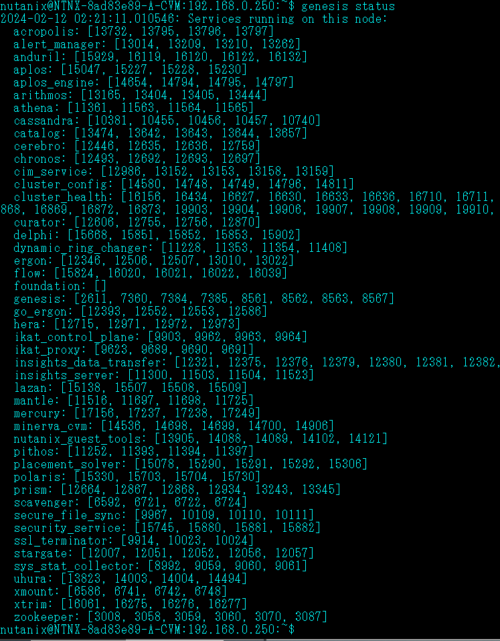

genesis statusも確認してみます。

クラスターを起動するには、cluster startを入力する必要があります。

暫くすると、サービスが全て起動したことがわかります。

※cluster stopでクラスターを停止することが可能です。次の「パルス」コマンドを使用する場合は、まずこのコマンドでクラスターを停止する必要があります。

※cluster destroyでクラスターを破壊することも可能です。Nutanix界のパルスです。

シングルクラスターからマルチクラスターに変更する場合に使用します。一度、クラスターを破壊しなければ、シングルノードクラスターからマルチノードクラスターにすることが出来ないためです。ただし、あくまでも検証用途で使用する場合に限ります。商用製品では絶対に使用禁止です。全てのデータが消失します。

genesis statusも確認してみると、先ほどとは異なり全てのサービスが起動しています。

念のため全てのCVMが起動しているか確認してみる

3ノード以上の構成でクラスターを作成した場合は、各AHVホストのノードでCVMが稼働しています。任意のCVMにログイン後、以下のコマンドを打つことでCVMが全て起動しているか確認することが可能です。

nutanix@cvm: hostssh virsh list --title ============= 192.168.0.111 ============ Id Name State Title --------------------------------------------- 1 NTNX-b8dd5b55-A-CVM running ============= 192.168.0.115 ============ Id Name State Title --------------------------------------------- 1 NTNX-b4adb210-A-CVM running ============= 192.168.0.113 ============ Id Name State Title --------------------------------------------- 1 NTNX-1002f418-A-CVM running

allsshは全てのCVMへ一度に同じコマンドを投入したい場合に使用します。

hostsshは全てのAHVへ一度に同じコマンドを投入したい場合に使用します。

PrismのWebコンソールへのログインと初期設定

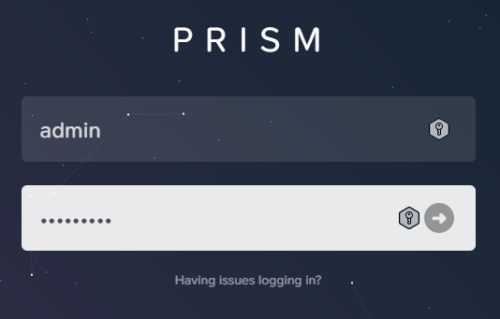

ここまで完了したら、WebコンソールであるPrismへログインすることが可能となります。

ブラウザを立ち上げて、https://CVMのIPアドレス:9440を入力します。

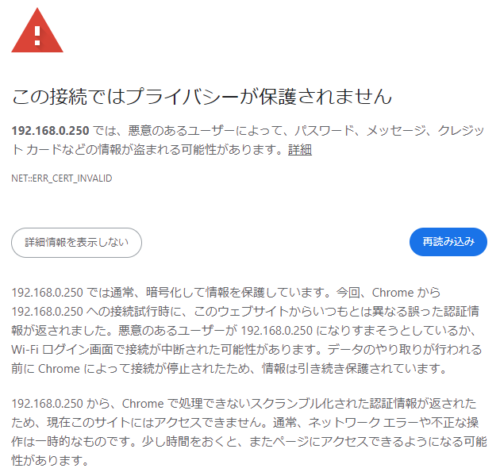

デフォルトの自己署名書では、root証明書で正当性を確認することができないため警告画面が表示されます。ブラウザの適当なところをクリックした上で、thisisunsafeと入力することでログイン画面に遷移します。

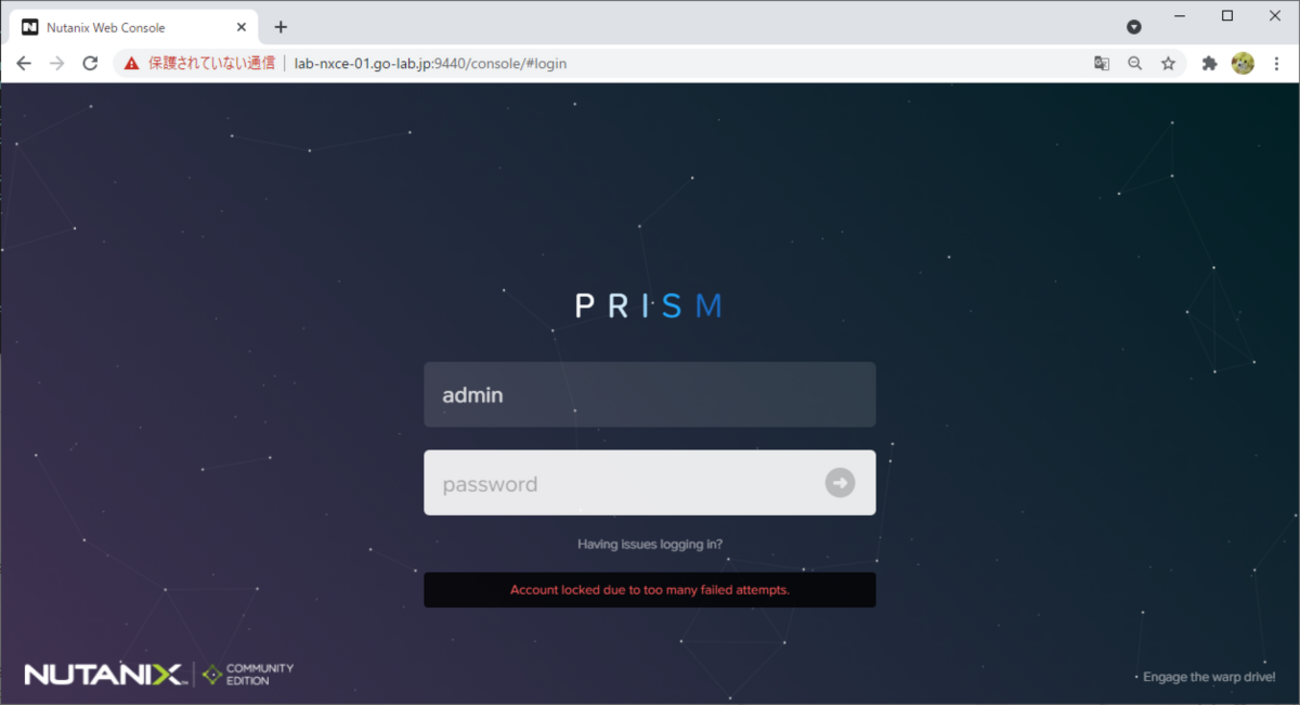

ログイン画面が表示されました。

ここで、ログイン情報を入力すると、パスワード変更を求められます。

しかし、下記の初期設定を全てCLIで完了させたいと思います。後ほどログインします。

パスワード変更(CVM)

CVM, AHV共にLinuxの標準コマンドでパスワードを変更することができます。

まずは、CVMからパスワード変更を行います。

任意の1台のCVMで実行します。次に紹介するコマンドは全て1台にだけ設定すれば問題ありません。

sudo su passwd admin passwd nutanix

admin…Webコンソールログインで使用する管理者アカウント

Nutanix…CVMのSSH接続時に使用するアカウント。ただし、将来的にはadminに統合されるそうです。

また、adminのみパスワード期限が60日に設定されています。パスワード変更ポリシー次第ですが、個人で検証する分には無期限の方が都合が良いので、下記のコマンドを投入します。

sudo chage -I -1 -m 0 -M 99999 -E -1 admin

そして、デフォルトではパスワードを変更する場合は、過去に使用したものは5世代にわたり使用不可となります。下記コマンドでPAMの設定を修正してあげてください。

mkdir -p backup/pam/ cp /etc/pam.d/system-auth-local ./backup/pam/system-auth-local.backup ll backup/pam/system-auth-local.backup vi /etc/pam.d/system-auth-local #19行目をコメントアウトしてください。

# password required pam_pwhistory.so retry=3 remember=5 enforce_for_root use_authok

パスワード変更(AHV)

2024/7/8追記

AHVについては次の記事で紹介する方法が正式な方法となります。

AHVへは内部の仮想スイッチ経由でCVMと接続されています。192.168.5.1で接続可能です。試しに、CVMから接続してみましょう。

AHVの場合は下記のユーザーのパスワードを変更します。

sudo su passwd admin passwd root

また、adminのみパスワード期限が60日に設定されています。パスワード変更ポリシー次第ですが、個人で検証する分には無期限の方が都合が良いので、下記のコマンドを投入します。

sudo chage -I -1 -m 0 -M 99999 -E -1 admin

そして、デフォルトではパスワードを変更する場合は、過去に使用したものは5世代にわたり使用不可となります。下記コマンドでPAMの設定を修正してあげてください。

mkdir -p backup/pam/

cp /etc/pam.d/system-auth-local ./backup/pam/system-auth-local.backup

ll backup/pam/system-auth-local.backup

vi /etc/pam.d/system-auth-local

#19行目をコメントアウト

# password required pam_pwhistory.so retry=3 remember=5 enforce_for_root use_authok

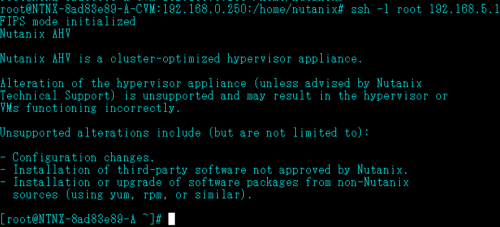

ホスト名の変更(AHV)

ホスト名は以下の条件を満たす範囲で任意の名前を付ける事が可能です。

- 63文字以内

- 大文字小文字の英字、数字、ドット(.)、ハイフン(-)を利用可能

- ホスト名の始めと終わりは英字もしくは数字になること

コマンドは以下の通りです。CVMにnutanixユーザーでログインした状態で実行してください。

change_ahv_hostname --host_ip=host-IP-address --host_name=new-host-name

画像は実行例となります。

AHVにログインしてホスト名が変更されたことを確認します。

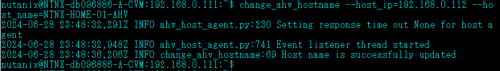

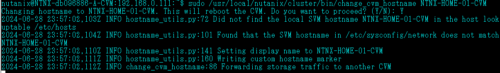

ホスト名の変更(CVM) ※SSH接続時

CVMのデフォルトの名前は以下の通りです。

NTNX-<block_serial>-<position-in-block>-CVM

ホスト名は以下の条件を満たす範囲で任意の名前を付ける事が可能です。

- ホスト名の始めはNTNXで始まること

- ホスト名の最後はCVMで終わること

- PCVM(Prism Central VM)の場合は、PCVMで終わること

コマンドは以下の通りです。

sudo /usr/local/nutanix/cluster/bin/change_cvm_hostname NTNX-xxx-A-CVM

CVMにnutanixユーザーでログインした状態で実行してください。

1台ずつしか実行できません。3ノードクラスターの場合最低でも15分程度かかります。

画像は実行例となります。再起動する必要があるため、Yを選択します。

5分程度待ちます。

CVMにログインしてホスト名が変更されたことを確認します。

![]()

その後、以下のコマンドをおまじまいとして投入しておいてください。

genesis start cluster start

その際、メンテナンスモードのままになっている可能性があります。

CVM: 192.168.0.111 Maintenance

以下のコマンドで解除します。nutanixユーザーで実行します。

nutanix@CVM:192.168.0.111:~$ acli host.exit_maintenance_mode AHVのIPアドレス ExitMaintenanceMode: pending ExitMaintenanceMode: complete

ただし、起動直後では内部処理がまだ完了していないため、次のようなメッセージが出力されます。5分程度待ちましょう。

Failed to connect to server: [Errno 111] Connection refused

ホスト名の変更(CVM) ※Prismコンソール時

コマンドは以下の通りです。CVMにnutanixユーザーでログインした状態で実行してください。

change_cvm_display_name --cvm_ip=<IP of CVM that should be renamed> --cvm_name=<new name>

以下は実行例となります。今回は失敗しています。他のCVMから実行する必要があるためです。

nutanix@NTNX-HOME-01-CVM:192.168.0.111:~$ change_cvm_display_name --cvm_ip=192.168.0.111 --cvm_name=NTNX-HOME-01-CVM

2024-06-29 11:00:28,812Z INFO change_cvm_display_name:207 Attempting to change the display na me of the CVM

2024-06-29 11:00:28,814Z WARNING zookeeper_session.py:160 Going to replace the passed host_po rt_list: zk1:9876,zk2:9876,zk3:9876 with the ZOOKEEPER_HOST_PORT_LIST environment variable: z k1:9876 because the passed host_port_list appears to have been copied from FLAGS.zookeeper_ho st_port_list

2024-06-29 11:00:28,814Z INFO zookeeper_session.py:191 change_cvm_display_name is attempting to connect to Zookeeper

2024-06-29 11:00:28,830Z INFO zookeeper_session.py:625 ZK session establishment complete, ses sionId=0x19063a50e0700d8, negotiated timeout=20 secs

2024-06-29 11:00:28,831Z INFO change_cvm_display_name:125 Retrieving the name of the CVM for the host

2024-06-29 11:00:29,229Z INFO change_cvm_display_name:156 Running prechecks before execution of script

2024-06-29 11:00:29,229Z INFO change_cvm_display_name:162 Running on AHV host

2024-06-29 11:00:29,230Z ERROR change_cvm_display_name:166 Script needs to be run from a diff erent CVM

2024-06-29 11:00:29,230Z ERROR change_cvm_display_name:232 Failed in prechecks stage

別のCVMの場合ものとなりますが、成功例です。

nutanix@CVM:192.168.0.124:~$ change_cvm_display_name --cvm_ip=192.168.0.126 --cvm_name=NTNX-HOME-03-CVM 2024-09-15 17:19:28,940Z INFO change_cvm_display_name:261 Attempting to change the display name of the CVM 2024-09-15 17:19:28,941Z INFO zookeeper_session.py:136 Using multithreaded Zookeeper client library: 1 2024-09-15 17:19:28,947Z INFO zookeeper_session.py:248 Parsed cluster id: 764767563958337793, cluster incarnation id: 1726415098426338 2024-09-15 17:19:28,947Z INFO zookeeper_session.py:270 change_cvm_display_name is attempting to connect to Zookeeper, host port list zk1:9876,zk2:9876,zk3:9876 2024-09-15 17:19:29,016Z INFO change_cvm_display_name:141 Retrieving the name of the CVM for the host 2024-09-15 17:19:29,254Z INFO zookeeper_session.py:840 ZK session establishment complete, sessionId=0x391f6a239b100e8, negotiated timeout=20 secs 2024-09-15 17:19:30,360Z INFO change_cvm_display_name:173 Running prechecks before execution of script 2024-09-15 17:19:30,361Z INFO change_cvm_display_name:179 Running on AHV host 2024-09-15 17:19:30,361Z INFO change_cvm_display_name:185 Running on different CVM 2024-09-15 17:19:30,361Z INFO change_cvm_display_name:192 Display name is validated

DNSサーバの修正

AHVからCVMへログインします。CVMへ直接ログインでもどちらでも構いません。

以降、ncliで始まるコマンドは全てCVMで投入します。

[root@NutanixCE2 admin]# ssh -l nutanix 192.168.5.254

デフォルトでは8.8.8.8と8.8.4.4が設定されています。変更する場合は以下の通りです。

ncli cluster remove-from-name-servers servers=8.8.8.8 ncli cluster remove-from-name-servers servers=8.8.4.4 ncli cluster add-to-name-servers servers="任意のDNSサーバ"

以下はコマンド例です。最大3つまでDNSサーバを設定することが可能です。

ncli cluster remove-from-name-servers servers=8.8.8.8 ncli cluster remove-from-name-servers servers=8.8.4.4 ncli cluster add-to-name-servers servers=1.1.1.1 ncli cluster add-to-name-servers servers=1.0.0.1 ncli cluster add-to-name-servers servers=1.1.1.2

参考:https://qiita.com/h_tyokinuhata/items/1684ab0b2f039f1c64eb

NTPサーバの修正

下記のコマンドで対応可能です。

ncli cluster remove-from-ntp-servers servers=0.pool.ntp.org ncli cluster add-to-ntp-servers servers="任意のDNSサーバ"

以下はコマンド例です。

ncli cluster remove-from-ntp-servers servers=0.pool.ntp.org ncli cluster add-to-ntp-servers servers=time.aws.com ncli cluster add-to-ntp-servers servers=time.cloudflare.com ncli cluster add-to-ntp-servers servers=ntp.nict.jp

ゾーンの修正

以下のコマンドを入力します。

ncli cluster set-timezone timezone=Asia/Tokyo

CVMのサービス再起動を求められるのでyを入力します。

nutanix@CVM$ ncli cluster set-timezone timezone=Asia/Tokyo Daily/weekly/monthly DR schedules are impacted by cluster timezone change. Please remove existing daily/weekly/monthly DR schedules before proceeding and reconfigure those schedules later to follow the new timezone. Do you want to continue.(y/N)?: y Please reboot the CVM or restart all services on the cluster so that logs are timestamped with the new Timezone.

クラスターネームの修正

下記のコマンドで対応可能です。

ncli cluster edit-params new-name="任意の名前"

コマンド例となります。

ncli cluster edit-params new-name=CE-Cluster

CVMのVirtual-IP-Addressの設定

下記のコマンドで対応可能です。

ncli cluster edit-params external-ip-address=192.168.0.254

※CVMのIPアドレスと同じセグメントにする必要があります。

※シングルクラスターなら不要な設定となります。

ncli cluster get-params | grep ‘External IP address’ で確認できます。

nutanix@CVM:192.168.0.250:~$ ncli cluster get-params | grep 'External IP address' External IP address : 192.168.0.254

プロキシサーバの設定(社内NWを使用している場合は基本必須)

社内の余ったサーバを使用してCEをインストールする場合など、プロキシサーバを経由してインターネットにアクセスする必要がある環境では、NEXTアカウントの認証を成功させるために、プロキシサーバの設定を必ず行う必要があります。

こちらのドキュメントを参照して、ncliコマンドでプロキシサーバを設定してください。

次の記事でプロキシサーバで許可するべきドメイン名(URL)を一覧化しております(随時更新)。

Webコンソールへログイン(再)

いよいよ、Webコンソールでログインします。

5回連続で間違えると、アカウントがロックされます。

ロックされた場合は、下記のブログを参照してロック解除してください(簡単)。

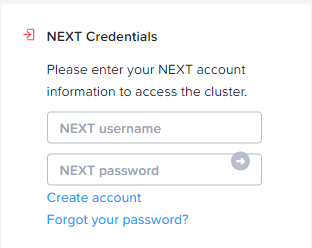

初回はNEXT Credentialsへ認証情報を提供する必要があります

アカウントを作成していない場合はcreate accountから新規作成しましょう。

こちらも、@yahoo.co.jpや@gmail.comなどは不可となります。必ず社用メールを使用してください。

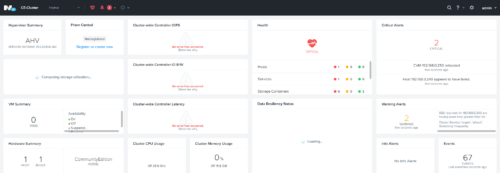

ログインに成功するとダッシュボードが表示されます(エラーばっかり)

→これは、クラスター作成時に–redundancy_factor=1を忘れたためです。

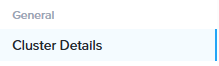

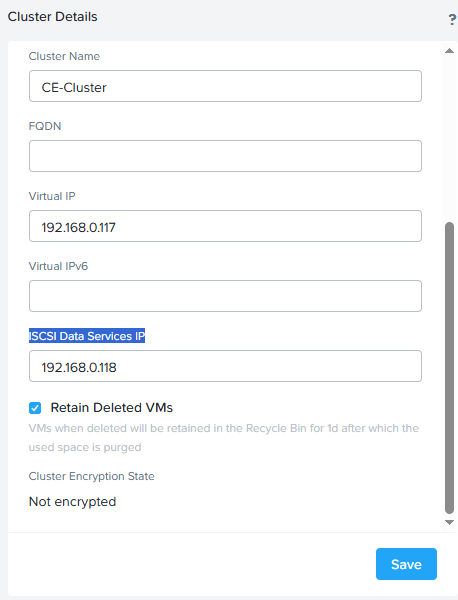

iSCSI Data Services IPの設定

Settings > GeneralにあるCluster Detailsをクリックします。

その中にiSCSI Data Services IPという項目があります。

CVMと同じセグメントでIPアドレスを付与します。

実は、iSCSI Data Services IPはシングルクラスターでは不要です。

マルチクラスター構成の場合に、複数のCVMを用いてI/O処理を行うことを実現することができます。これにより、1つのCVMがボトルネックとなってI/O処理が低下することを防ぐことが出来ます。Nutanix Volumes、Files、Objects、Calmなど、幅広いサービスで使用されます。

ストレージコンテナーの圧縮の有効化

ストレージ > テーブルからストレージコンテナーの設定状況を確認することができます。デフォルトでは、一般的に使用するdefaut-containerの圧縮設定がオフになっているので、これをオンにします。イメージの格納用途で用意されているSelfServiceContainerについてもオンにします。オフにするメリットがないので基本的にはオンが推奨です。

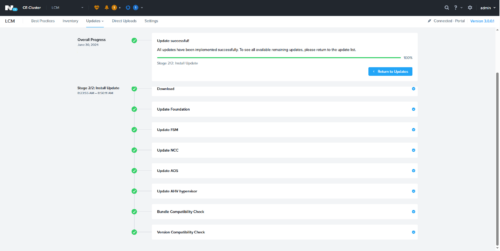

LCMによるソフトウェアのアップグレード

ここからは必須ではありませんが、LCM(Life Cycle Management)の紹介とLCMによるアップデートの使い方を簡単に紹介します。残念ながら、先ほどのエラーが発生している状態ではLCMは上手く動作しませんでした。

LCMとは、Nutanixのソフトウェア管理ツールとなります。常にクラウド上のリポジトリと接続している状態では、手動もしくは特定の時間帯に自動で、最新版のソフトウェアをダウンロードすることが可能です。インターネットに接続できない場合は、直接サポートポータルのダウンロードサイトから入手したソフトウェアをアップロードすることも可能です。また、1クリックでUpgradeを行うことができます。AOS(CVMの中核ソフトウェア)、AHV、NCC(Nutanix Cluster Check)、LCM、Nutanix Filesといったソフトウェアが対応しています。一部は、LCMでアップグレードすることができません。CMU(Cluster Maintenance Utilities)などです。

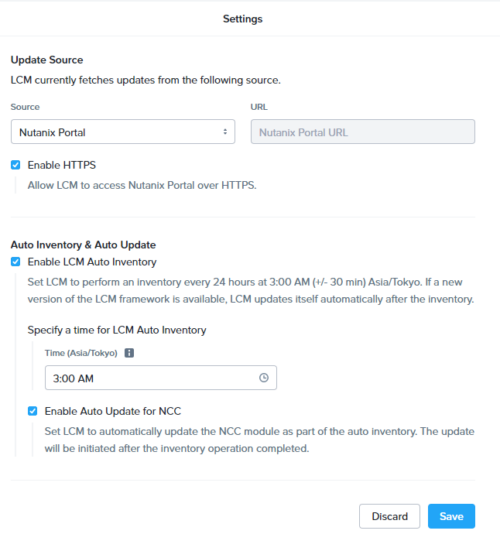

SettingsからLCMを選択します。

※キーボードのmボタンでこの画面を開くことが可能です。

常に最新版の状態に保ちたい場合はSettingsにてAuto Inventory & Auto Updateのチェックを全てつけておくことをお勧めします。

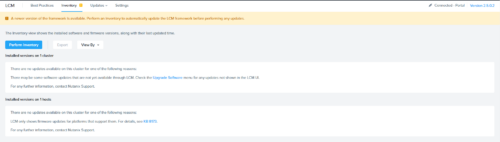

インストールしたばかりの状態では、様々なソフトウェアのバージョンが古いままです。

Perform Inventoryをクリックすることで、各種ソフトウェアをダウンロードすることができます。完了後は、Updatesタブから確認することが可能です。

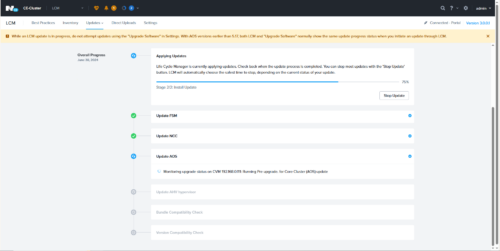

完了したら、Upgradeしておきましょう。

AOSとAHVのアップグレードが完了するタイミングでCVMが再起動します。しかし、CVMの各種サービスが自動的に起動しません。

nutanix@CVM:192.168.0.111:~$ genesis status 2024-06-29 23:49:54.300565: Services running on this node: acropolis: [] alert_manager: [] anduril: [] aplos: [] aplos_engine: [] arithmos: [] athena: [] cassandra: [] catalog: [] cerebro: [] chronos: [] cim_service: [] cluster_config: [] cluster_health: [] curator: [] delphi: [] dynamic_ring_changer: [] ergon: [] flow: [] foundation: [] genesis: [] go_ergon: [] ikat_control_plane: [] ikat_proxy: [] insights_data_transfer: [] insights_server: [] lazan: [] mantle: [] mercury: [] minerva_cvm: [] nutanix_guest_tools: [] pithos: [] placement_solver: [] polaris: [] prism: [] scavenger: [] secure_file_sync: [] security_service: [] ssl_terminator: [] stargate: [] sys_stat_collector: [] uhura: [] xmount: [] xtrim: [] zookeeper: []

そのため、次のコマンドを流し込んでおきましょう。

nutanix@CVM:192.168.0.111:~$ genesis start Genesis is already running, pids: [7737, 7875, 7914, 7915] nutanix@NTNX-HOME-01-CVM:192.168.0.111:~$ cluster start 2024-06-29 14:51:53,882Z INFO MainThread zookeeper_session.py:191 cluster is attempting to connect to Zookeeper ~以下省略~

※なぜかcluster startがsuccess!と表示されてもサービスが起動していない場合がありました。cluster startをもう一度実行してください。genesis statusやcluster statusでサービスが全て起動していることを確認してください。

完了したら画像のような画面になります。

無事にバージョンアップが完了しました。

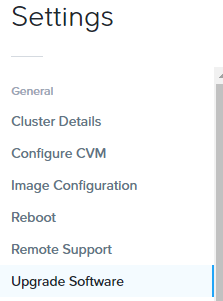

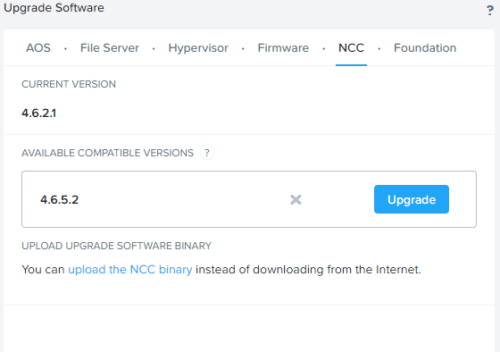

ソフトウェアのアップグレード(LCM以外から)

SettingsからUpgrade Softwareをクリックします。

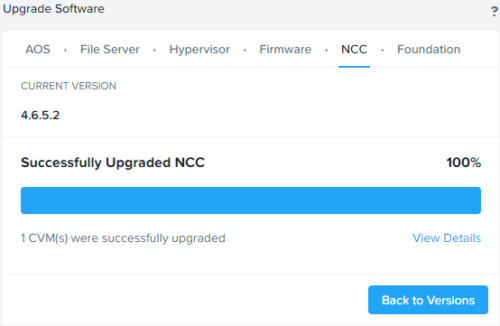

LCMを実行しない初期状態では、NCC、Foundationのバージョンが古いため、最新バージョンにUpgradeしておくと良いでしょう。

成功すると、下記のように表示されます。

最後に

物凄く丁寧に整理されたドキュメントを発見したので共有です。

https://www.actcrp.com/actdepo/otherinfo/NutanixClusterSetUpMemoRev6.pdf

参考ドキュメント

コメント